De-Robots, il progetto per la trasparenza dei siti pubblici presentato al Chaos Computer Congress di Amburgo da un italiano svela l’uso del protocollo “Robots” dei nostri amministratori

Nelle scorse settimane si è tenuto ad Amburgo l’annuale conferenza europea di hacking del Chaos Computer Club (33c3). Molti sono stati i talk di grande interesse come quello tenuto da Karsten Nohl sullo scarso livello di sicurezza dei sistemi che gestiscono le informazioni dei voli nel settore turistico (ve ne parlerò nei prossimi giorni ;-)).

Tra i vari esperti vi era anche Fabio Pietrosanti, uno dei maggiori esperti europei in materia cyber security e privacy, che ha presentato un talk dal titolo “Robots txt abuses by government agencies against transparency“

Fabio ha approfondito il livello di trasparenza delle informazioni offerto dai vari governi partendo da un singolare punto di vista, quelli dei motori di ricerca.

Come funziona Robots.txt

I motori di ricerca come Google utilizzano applicazioni note come “web crawler” per analizzare tutti i contenuti esposti in rete ed indicizzarli.

I gestori dei siti hanno tuttavia la possibilità di evitare che i contenuti dei loro siti siano indicizzati dai motori di ricerca utilizzando dei file noti come Robots.txt.

Ciascun sito ha un suo file robot.txt in cui sono presenti gli indirizzi di tutti quei contenuti che il gestore del sito non intende che vengano indicizzati dai motori di ricerca.

Figura 1 – Esempio di File Robot.txt

La sintassi utilizzata per l’editing di questi file è semplice, aprendone uno troveremo le seguenti parole chiave:

User-agent: Nome del crawler per il quale valgono le regole che seguono. È possibile usare un carattere jolly ‘*’ per far si che le regole valgano per qualunque crawler.

Disallow: Indirizzo che non si intende indicizzare.

Allow: Indirizzo che si intende indicizzare e che è presente in una sottodirectory di una directory bloccata ai crawler.

Cosa accade se il sito che analizziamo è un sito web di un Governo? Accedendo il file robot.txt potremo prendere visione di quali contenuti il gestore del sito intendere nascondere ai motori di ricerca.

Per molti tutto questo potrebbe apparire come una cosa assurda. Da un lato si pubblicano contenuti su server esposti in rete e dall’altro si cerca di impedirne l’indicizzazione, ma i contenuti sono li, alla portata di tutti. Basta andare a leggere il file robot.txt e vedere quali sono i contenuti che si cerca di nascondere e dove sono

Fabio Pietrosanti ha deciso di analizzare i contenuti che seppur esposti in rete, non sono indicizzati dai motori di ricerca per volontà della PA perché i link relativi sono esplicitamente bloccati attraverso il meccanismo dei robot.txt.

SenzaFiltri, un progetto per la trasparenza amministrativa

Il progetto SenzaFiltri, o De-Robots, si prefigge quindi l’analisi di tutti i contenuti nascosti ai motori di ricerca dalle agenzie governative e di renderli disponibili agli utenti della rete.

Il fine ultimo è quello di aumentare implementare la trasparenza della pubblica amministrazione nei confronti dei propri cittadini.

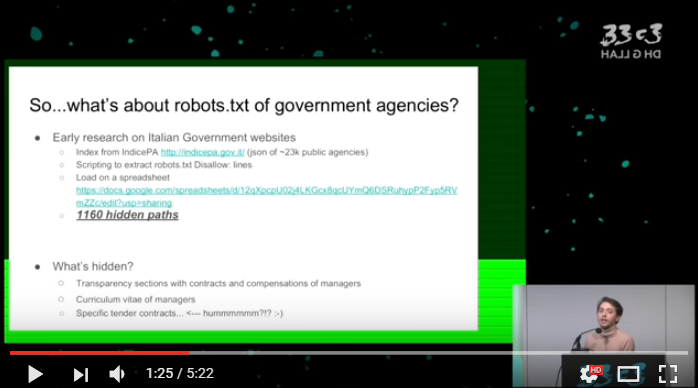

Fabio Pietrosanti ha mostrato nel corso del suo talk i risultati ottenuti dall’analisi dei robot.txt dei siti web della PA italiana, parliamo di circa 23,000 siti presenti nell’indicePA.

Il processo è estremamente semplice, ma trovo geniale quanto interessante l’attività condotta per il progetto.

Gli esperti hanno utilizzato degli script per estrarre i file robots.txt da questi siti e da essi tutte le linee che riportavano la direttiva “Disallow,” ovvero quei file pubblicati su server della PA che “qualcuno” intenzionalmente o per errore ha deciso di non far visitare ai motori di ricerca.

La ricerca ha prodotto ben 1160 percorsi nascosti ai motori di ricerca e riportati nel seguente file:

Ne è emersa una gran mole di documenti: porzioni di interi siti web, atti parlamentari, curricula e stipendi dei manager della PA italiana.

Figura 2 – Screenshot del talk

La Camera dei deputati e gli indirizzi nascosti

Tra gli indirizzi spiccano quelli nascosti sul sito della Camera dei Deputati il cui file robot.txt è reperibile all’indirizzo: http://www.camera.it/robots.txt

Una volta scovati gli indirizzi nascosti renderli pubblici è stato un gioco da ragazzi, i responsabili del progetto hanno registrato un dominio (senzafiltri.org) ed attraverso un meccanismo di reverse proxing hanno reso accessibili i link nascosti con il seguente indirizzo

http://originalsite.senzafiltri.org/PathNascosta

Facendo una rapida ricerca su Google (cercate site:senzafiltri.org) potremo constatare che al momento sono state indicizzati dal popolare motore di ricerca ben 46.000 percorsi nascosti.

Purtroppo mentre vi scrivo il sito del progetto senzafiltri.org non sembra essere raggiungibile.

A questo punto è auspicabile che tutti gli amministratori di siti web istituzionali facciano un verifica del contenuto che è esposto in rete, seppur non indicizzato. Per errore o dimenticanza potrebbero finire in rete documenti contenenti informazioni sensibili.

Vi ricorso che i file robot.txt sono anche creati in modo automatico dai principali CMS con regole di default, è quindi necessario prenderne visione per comprendere cosa si rende disponibile all’indicizzazione.

Il progetto De-Robots dovrebbe proseguire, come spiegato da Pietrosanti durante il talk, l’intento è quello di produrre un software per la pubblicazione dei percorsi nascosti e di implementare un motore di ricerca indipendente per gli attivisti della rete che consenta a chiunque di prendere visione di tutti i documenti nascosti (“lasciatemi dire in modo maldestro”) dai governi locali.

Dimenticavo … vi suggerisco di prendere visione della presentazione fatta da Fabio Pietrosanti ad Amburgo.